Recentemente, il team cinese ha suscitato grande interesse con il lancio di DeepSeek-V3. Cos'è DeepSeek-V3? In breve, si tratta di un LLM (modello di linguaggio di grandi dimensioni) basato sull'architettura MoE con un totale di 671 miliardi di parametri, di cui 37 miliardi vengono attivati per ogni token. Secondo le valutazioni, DeepSeek-V3 supera altri modelli open-source ed è in grado di competere con i principali modelli a codice chiuso.

Negli ultimi anni, gli LLM hanno subito una rapida evoluzione, riducendo progressivamente il divario con l'intelligenza artificiale generale (AGI). Nel campo dei modelli open-source, si sta assistendo a progressi significativi con modelli come DeepSeek, LLaMA, Qwen e Mistral, che stanno lavorando per colmare il divario di prestazioni con i modelli a codice chiuso. L'emergere di DeepSeek-V3 rappresenta una pietra miliare importante. Successivamente, forniremo una spiegazione tecnica più dettagliata su cosa sia DeepSeek, come utilizzarlo e molto altro!

- Anteprima del contenuto

Cos'è DeepSeek e DeepSeek-V3?

DeepSeek è una grande azienda di modelli con sede a Hangzhou, che ha lanciato il DeepSeek-Coder, il DeepSeek-V2 e altri modelli di linguaggio di grandi dimensioni per il pubblico. La startup è stata ufficialmente fondata il 17 luglio 2023 e l'azienda che la sostiene finanziariamente è la nota società High-Flyer Quant (un hedge fund orientato all'AI). DeepSeek è stata fondata con l'obiettivo di esplorare la natura dell'intelligenza artificiale generale (AGI) e promuovere l'avanzamento e l'applicazione della tecnologia AI attraverso la ricerca e lo sviluppo di tecnologie all'avanguardia, come i modelli di linguaggio di grandi dimensioni.

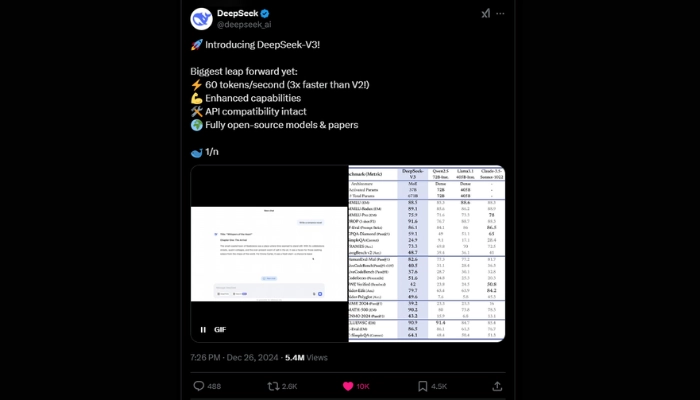

Il 26 dicembre è stata lanciata la prima versione di una nuova serie di modelli, Deepseek-V3, il cui codice è stato reso open-source contemporaneamente. DeepSeek V3 ha 671 miliardi di parametri, il che significa che è uno dei più grandi modelli di AI al mondo. I parametri sono variabili interne che aiutano l'AI a comprendere e rispondere ai compiti con maggiore precisione. Più parametri ci sono, maggiore è il potenziale del modello. E sotto questo aspetto, il V3 si distingue: è 1,6 volte più grande del Llama 3.1 di Meta, che ha 405 miliardi di parametri. (Fonte: Rivista Forum)

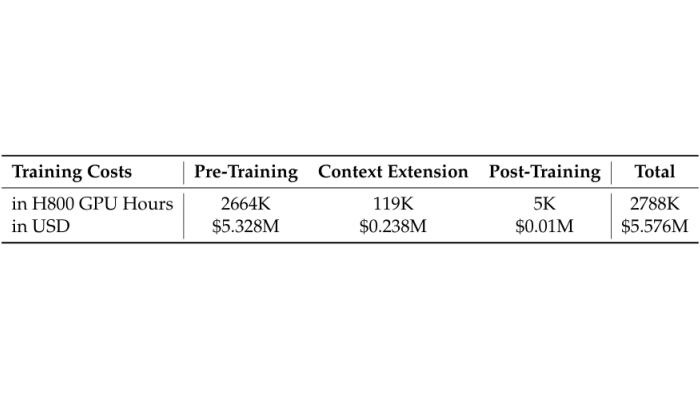

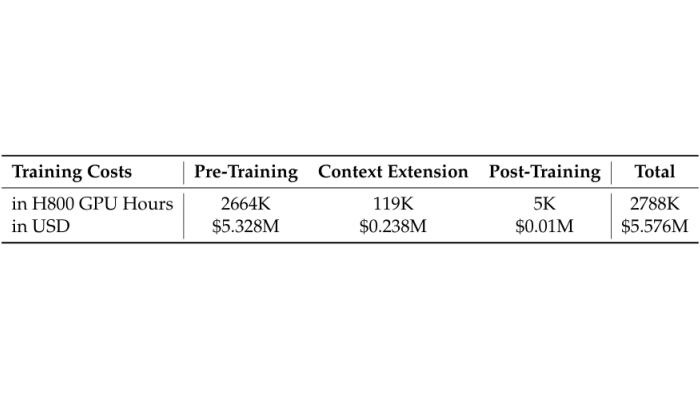

Degno di nota, DeepSeek-V3 raggiunge costi di addestramento molto competitivi. Basandosi sul prezzo di noleggio della GPU H800 di 2 dollari l'ora, il costo totale dell'addestramento è stato di soli 5,58 milioni di dollari, un valore impressionantemente basso rispetto ad altri modelli sul mercato, come il GPT-4 di OpenAI.

Si comprende que el equipo detrás de DeepSeek AI también tiene una característica distintiva: jóvenes, novatos y estudiantes, especialmente de la Universidad de Tsinghua y la Universidad de Pekín, son muy activos en su grupo.

Trasforma testo in video con l'AI - GRATIS

Crea video realistici e di alta qualità da PDF, PPT e URL con un solo clic!